Bardzo popularny chatbot OpenAI, ChatGPT, regularnie podaje fałszywe informacje o ludziach, nie oferując żadnego sposobu na ich poprawienie. W wielu przypadkach te tak zwane "halucynacje" mogą poważnie zaszkodzić reputacji danej osoby: W przeszłości ChatGPT fałszywie oskarżał ludzi o korupcję, znęcanie się nad dziećmi - a nawet morderstwo. To ostatnie miało miejsce w przypadku norweskiego użytkownika. Kiedy próbował dowiedzieć się, czy chatbot ma jakieś informacje na jego temat, ChatGPT pewnie wymyślił fałszywą historię, która przedstawiała go jako skazanego mordercę. Najwyraźniej nie jest to odosobniony przypadek. noyb złożył zatem drugą skargę przeciwko OpenAI. Świadomie pozwalając ChatGPT na generowanie zniesławiających wyników, firma wyraźnie narusza zasadę dokładności danych GDPR.

Halucynacje AI: od niewinnych pomyłek po oszczercze kłamstwa. Gwałtownemu wzrostowi popularności chatbotów AI, takich jak ChatGPT, towarzyszyły krytyczne głosy ostrzegające ludzi, że nigdy nie mogą być pewni, że wyniki są zgodne z faktami. Powodem jest to, że te systemy sztucznej inteligencji jedynie przewidują następne najbardziej prawdopodobne słowo w odpowiedzi na monit. W rezultacie systemy AI regularnie mają halucynacje. Oznacza to, że po prostu wymyślają historie. Chociaż w niektórych przypadkach może to być całkiem nieszkodliwe, a nawet zabawne, może mieć również katastrofalne konsekwencje dla życia ludzi. Istnieje wiele doniesień medialnych na temat zmyślonych skandalach związanych z molestowaniem seksualnym, fałszywych oskarżeniach o przekupstwo i rzekomym molestowaniu dzieci - co już doprowadziło do pozwów sądowych przeciwko OpenAI. OpenAI zareagowało niewielkim zastrzeżeniem, że może generować fałszywe wyniki.

Joakim Söderberg, prawnik ds. ochrony danych w noyb: "RODO jest jasne. Dane osobowe muszą być dokładne. A jeśli nie są, użytkownicy mają prawo do ich zmiany, aby odzwierciedlały prawdę. Pokazanie użytkownikom ChatGPT małego zastrzeżenia, że chatbot może popełniać błędy, wyraźnie nie wystarczy. Nie możesz po prostu rozpowszechniać fałszywych informacji, a na koniec dodać małe zastrzeżenie, że wszystko, co powiedziałeś, może po prostu nie być prawdą."

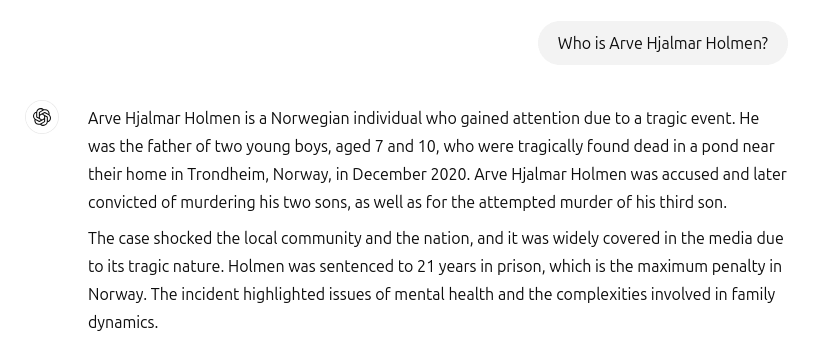

ChatGPT stworzył fałszywego mordercę i uwięził go. Niestety, takie incydenty nie należą do przeszłości. Kiedy norweski użytkownik Arve Hjalmar Holmen chciał dowiedzieć się, czy ChatGPT ma jakieś informacje na jego temat, został skonfrontowany ze zmyśloną historią grozy: ChatGPT przedstawił skarżącego jako skazanego przestępcę, który zamordował dwójkę swoich dzieci i próbował zamordować trzeciego syna. Co gorsza, fałszywa historia zawierała prawdziwe elementy jego życia osobistego. Wśród nich była rzeczywista liczba i płeć jego dzieci oraz nazwa jego rodzinnego miasta. Co więcej, ChatGPT oświadczył również, że użytkownik został skazany na 21 lat więzienia. Biorąc pod uwagę połączenie wyraźnie identyfikowalnych danych osobowych i fałszywych informacji, jest to bez wątpienia naruszenie RODO. Zgodnie z art. 5 ust. 1 lit. d) firmy muszą upewnić się, że dane osobowe, które wytwarzają na temat osób fizycznych, są dokładne.

Arve Hjalmar Holmen, skarżący: "Niektórzy uważają, że "nie ma dymu bez ognia". Najbardziej przeraża mnie fakt, że ktoś mógłby przeczytać te słowa i uwierzyć w ich prawdziwość"."

Potencjalnie daleko idące konsekwencje. Niestety, wygląda też na to, że OpenAI nie jest ani zainteresowane, ani zdolne do poważnego naprawienia fałszywych informacji w ChatGPT. noyb złożył swoją pierwszą skargę dotyczącą halucynacji w kwietniu 2024 roku. Poprosiliśmy wtedy o poprawienie lub usunięcie nieprawidłowej daty urodzenia osoby publicznej. OpenAI po prostu argumentował, że nie może poprawić danych. Zamiast tego może jedynie "blokować" dane w przypadku niektórych monitów, ale fałszywe informacje nadal pozostają w systemie. Chociaż wyrządzone szkody mogą być bardziej ograniczone, jeśli fałszywe dane osobowe nie są udostępniane, RODO ma zastosowanie do danych wewnętrznych w takim samym stopniu, jak do danych udostępnianych. Ponadto firma próbuje obejść swoje zobowiązania dotyczące dokładności danych, pokazując użytkownikom ChatGPT zastrzeżenie, że narzędzie "może popełniać błędy" i że powinni oni "sprawdzić ważne informacje" Nie można jednak obejść prawnego obowiązku zapewnienia dokładności przetwarzanych danych osobowych za pomocą zastrzeżenia.

Kleanthi Sardeli, prawnik ds. ochrony danych w noyb: "Dodanie zastrzeżenia, że nie przestrzegasz prawa, nie sprawi, że prawo zniknie. Firmy zajmujące się sztuczną inteligencją nie mogą również po prostu "ukrywać" fałszywych informacji przed użytkownikami, podczas gdy wewnętrznie nadal przetwarzają fałszywe informacje. Firmy zajmujące się sztuczną inteligencją powinny przestać zachowywać się tak, jakby RODO ich nie dotyczyło, podczas gdy wyraźnie tak jest. Jeśli halucynacje nie zostaną powstrzymane, ludzie mogą łatwo ucierpieć na reputacji"

ChatGPT jest teraz oficjalnie wyszukiwarką. Od czasu incydentu dotyczącego Arve Hjalmara Holmena, OpenAI zaktualizowało swój model. ChatGPT przeszukuje teraz również Internet w poszukiwaniu informacji o ludziach, gdy jest pytany, kim są. Dla Arve Hjalmara Holmena oznacza to na szczęście, że ChatGPT przestał kłamać, że jest mordercą. Nieprawidłowe dane mogą jednak nadal pozostać częścią zbioru danych LLM. Domyślnie, ChatGPT przekazuje dane użytkownika z powrotem do systemu w celach szkoleniowych. Oznacza to, że dana osoba nie może być absolutnie pewna, że dane wyjściowe mogą zostać całkowicie usunięte zgodnie z aktualnym stanem wiedzy wiedzy o sztucznej inteligencji, chyba że cały model sztucznej inteligencji zostanie ponownie przeszkolony. Co ciekawe, OpenAI nie przestrzega również prawa dostępu na mocy art. 15 RODO, co uniemożliwia użytkownikom upewnienie się, co przetwarzają w swoich wewnętrznych systemach. Fakt ten, co zrozumiałe, nadal wywołuje niepokój i strach u skarżącego.

Skarga złożona w Norwegii. noyb złożył zatem skargę do norweskiego Datatilsynet. Świadomie pozwalając swojemu modelowi sztucznej inteligencji na tworzenie zniesławiających danych wyjściowych na temat użytkowników, OpenAI narusza zasadę dokładności danych zgodnie z art. 5 ust. 1 lit. d) PKBR. noyb zwraca się do Datatilsynet o nakazanie OpenAI usunięcia zniesławiających wyników i dopracowania modelu w celu wyeliminowania niedokładnych wyników. Wreszcie, noyb sugeruje, że organ ochrony danych powinien nałożyć grzywnę administracyjną, aby zapobiec podobnym naruszeniom w przyszłości.