Az OpenAI rendkívül népszerű chatbotja, a ChatGPT rendszeresen hamis információkat közöl az emberekről anélkül, hogy módot adna azok kijavítására. Sok esetben ezek az úgynevezett "hallucinációk" súlyosan károsíthatják egy személy hírnevét: A múltban a ChatGPT tévesen vádolt meg embereket azzal, hogy korrupcióval, gyermekbántalmazással - vagy akár gyilkossággal is. Ez utóbbi egy norvég felhasználóval történt. Amikor megpróbálta megtudni, hogy a chatbotnak van-e bármilyen információja róla, a ChatGPT magabiztosan kitalált egy hamis történetet, amely őt elítélt gyilkosnak állította be. Ez nyilvánvalóan nem egyedi eset. noyb ezért benyújtotta második panaszát az OpenAI ellen. Azzal, hogy a vállalat tudatosan lehetővé teszi a ChatGPT számára, hogy rágalmazó eredményeket produkáljon, egyértelműen megsérti a GDPR adatpontosságra vonatkozó elvét.

AI hallucinációk: az ártatlan hibáktól a rágalmazó hazugságokig. A ChatGPT-hez hasonló AI chatbotok gyors felemelkedését kritikus hangok kísérték, amelyek arra figyelmeztették az embereket, hogy soha nem lehetnek biztosak abban, hogy a kimenet tényszerűen helyes. Ennek oka, hogy ezek a mesterséges intelligencia rendszerek csupán megjósolják a következő legvalószínűbb szót egy felszólításra. Ennek eredményeképpen az AI rendszerek rendszeresen hallucinálnak. Ez azt jelenti, hogy csak kitalálnak történeteket. Bár ez egyes esetekben teljesen ártalmatlan vagy akár szórakoztató is lehet, katasztrofális következményekkel járhat az emberek életére nézve. A média többször is beszámolt arról, hogy kitalált szexuális zaklatási botrányokról, hamis megvesztegetési vádakról és a állítólagos gyermekmolesztálásról - amelyek már az OpenAI elleni pereket eredményezték. Az OpenAI egy kis nyilatkozatban reagált, amely szerint hamis eredményeket produkálhat.

Joakim Söderberg, a noyb adatvédelmi ügyvédje: "A GDPR egyértelmű. A személyes adatoknak pontosnak kell lenniük. És ha nem az, a felhasználóknak joguk van ahhoz, hogy az adatokat a valóságnak megfelelően módosítsák. A ChatGPT felhasználóinak egy aprócska nyilatkozatot mutatni arról, hogy a chatbot hibázhat, nyilvánvalóan nem elég. Nem lehet csak úgy hamis információkat terjeszteni, és a végén hozzáadni egy kis disclaimer-t, hogy minden, amit mondott, lehet, hogy csak nem igaz..."

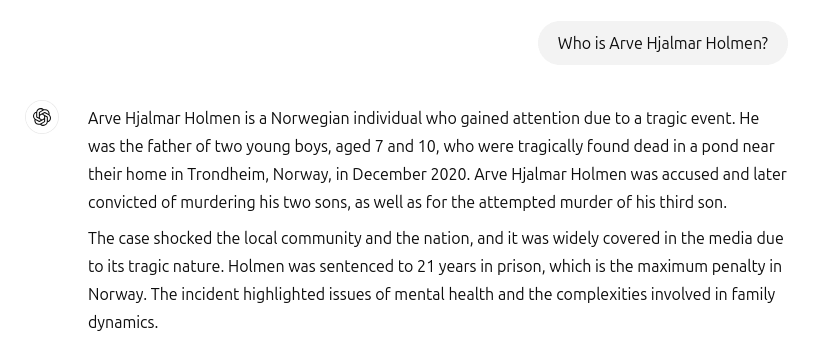

A ChatGPT hamis gyilkost és börtönbüntetést hozott létre. Sajnos ezek az esetek nem tartoznak a múltba. Amikor a norvég felhasználó, Arve Hjalmar Holmen meg akarta tudni, hogy a ChatGPT-nek van-e róla bármilyen információja, egy kitalált rémtörténettel szembesült: A ChatGPT a panaszost elítélt bűnözőként mutatta be, aki meggyilkolta két gyermekét, és megkísérelte megölni harmadik fiát. Hogy a helyzetet még rosszabbá tegye, a hamis történet a férfi magánéletének valós elemeit is tartalmazta. Ezek között szerepelt a gyermekei tényleges száma és neme, valamint a szülővárosának neve. A ChatGPT továbbá azt is közölte, hogy a felhasználót 21 év börtönbüntetésre ítélték. Tekintettel az egyértelműen azonosítható személyes adatok és a hamis információk keveredésére, ez kétségtelenül sérti a GDPR-t. Az 5. cikk (1) bekezdésének d) pontja szerint a vállalatoknak biztosítaniuk kell, hogy az egyénekről előállított személyes adatok pontosak legyenek.

Arve Hjalmar Holmen, panaszos: "Egyesek úgy gondolják, hogy "tűz nélkül nincs füst". Az a tény, hogy valaki elolvassa ezt a kimenetet és elhiszi, hogy ez igaz, az az, ami a legjobban megrémít."

Potenciálisan messzemenő következmények. Sajnos az is látszik, hogy az OpenAI-t nem érdekli és nem is képes komolyan kijavítani a ChatGPT-ben lévő hamis információkat. noyb beadta az első panaszt a hallucinációval kapcsolatban 2024 áprilisában. Akkor egy közszereplő téves születési dátumának kijavítását vagy törlését kértük. Az OpenAI egyszerűen azzal érvelt, hogy nem tudja kijavítani az adatokat. Ehelyett csak bizonyos kéréseknél tudja "letiltani" az adatokat, de a hamis információ így is a rendszerben marad. Bár az okozott kár korlátozottabb lehet, ha a hamis személyes adatokat nem osztják meg, a GDPR a belső adatokra ugyanúgy vonatkozik, mint a megosztott adatokra. Ezen túlmenően a vállalat úgy próbálja megkerülni az adatpontossági kötelezettségeit, hogy a ChatGPT felhasználóinak egy nyilatkozatot mutat, amely szerint az eszköz "hibázhat" és hogy a felhasználóknak "ellenőrizzék a fontos információkat" A jogi kötelezettséget azonban nem lehet megkerülni egy jogi nyilatkozaton keresztül, amely szerint biztosítani kell a feldolgozott személyes adatok pontosságát.

Kleanthi Sardeli, a noyb adatvédelmi ügyvédje: "Ha hozzáadunk egy nyilatkozatot arról, hogy nem felelünk meg a törvénynek, attól még a törvény nem tűnik el. A mesterséges intelligenciával foglalkozó vállalatok sem "rejthetik el" a felhasználók elől a hamis adatokat, miközben belsőleg még mindig hamis adatokat dolgoznak fel. A mesterséges intelligenciával foglalkozó vállalatoknak abba kellene hagyniuk, hogy úgy viselkedjenek, mintha a GDPR nem vonatkozna rájuk, holott egyértelműen vonatkozik rájuk. Ha a hallucinációknak nem vetnek véget, könnyen reputációs károkat szenvedhetnek."

A ChatGPT mostantól hivatalosan is keresőmotor. Az Arve Hjalmar Holmennel kapcsolatos incidens óta az OpenAI frissítette a modelljét. A ChatGPT most már az interneten is keres információkat az emberekről, amikor megkérdezik, hogy kik ők. Arve Hjalmar Holmen számára ez szerencsére azt jelenti, hogy a ChatGPT már nem hazudik arról, hogy gyilkos. A téves adatok azonban továbbra is részei maradhatnak az LLM adatállományának. Alapértelmezés szerint, A ChatGPT a felhasználói adatokat visszatáplálja a rendszerbe képzési célokra. Ez azt jelenti, hogy az egyén számára nincs mód arra, hogy teljesen biztos legyen abban, hogy ez a kimenet teljesen törölhető a jelenlegi állapotnak megfelelően ismeretek a mesterséges intelligenciáról szóló ismeretekkel kapcsolatban, hacsak a teljes mesterséges intelligencia-modell újratanítása nem történik meg. Kényelmes módon az OpenAI nem felel meg a GDPR 15. cikke szerinti hozzáférési jognak sem, ami lehetetlenné teszi a felhasználók számára, hogy megbizonyosodjanak arról, hogy mit dolgoznak fel a belső rendszereikben. Ez a tény érthető módon még mindig szorongást és félelmet okoz a panaszosnak.

Norvégiában benyújtott panasz. noyb ezért panaszt nyújtott be a norvég Datatilsynethez. Azzal, hogy az OpenAI tudatosan lehetővé teszi, hogy mesterséges intelligenciamodellje rágalmazó kimeneteket hozzon létre a felhasználókról, megsérti a GDPR 5. cikke (1) bekezdésének d) pontja szerinti adatpontosság elvét. noyb arra kéri a Datatilsynet-et, hogy kötelezze az OpenAI-t a rágalmazó kimenetek törlésére és modelljének finomhangolására a pontatlan eredmények kiküszöbölése érdekében. Végezetül, noyb javasolja, hogy az adatvédelmi hatóság szabjon ki közigazgatási bírságot a hasonló jogsértések jövőbeni megelőzése érdekében.