De zeer populaire chatbot van OpenAI, ChatGPT, geeft regelmatig onjuiste informatie over mensen zonder een manier te bieden om dit te corrigeren. In veel gevallen kunnen deze zogenaamde "hallucinaties" iemands reputatie ernstig schaden: In het verleden beschuldigde ChatGPT mensen valselijk van corruptie, kindermisbruik - of zelfs moord. Dat laatste was het geval bij een Noorse gebruiker. Toen hij wilde weten of de chatbot informatie over hem had, verzon ChatGPT zelfverzekerd een nepverhaal waarin hij werd afgeschilderd als een veroordeelde moordenaar. Dit is duidelijk geen geïsoleerd geval. noyb heeft daarom zijn tweede klacht ingediend tegen OpenAI. Door ChatGPT willens en wetens lasterlijke resultaten te laten produceren, schendt het bedrijf duidelijk het GDPR-beginsel van nauwkeurigheid van gegevens.

AI-hallucinaties: van onschuldige fouten tot lasterlijke leugens. De snelle opkomst van AI-chatbots zoals ChatGPT ging gepaard met kritische stemmen die mensen waarschuwden dat ze er nooit zeker van kunnen zijn dat de output feitelijk correct is. De reden hiervoor is dat deze AI-systemen slechts het volgende meest waarschijnlijke woord voorspellen als reactie op een prompt. Het gevolg is dat AI-systemen regelmatig hallucineren. Dit betekent dat ze gewoon verhalen verzinnen. Hoewel dit in sommige gevallen heel onschuldig of zelfs amusant kan zijn, kan het ook rampzalige gevolgen hebben voor het leven van mensen. Er zijn meerdere mediaberichten over verzonnen seksuele intimidatieschandalen, valse beschuldigingen van omkoping en vermeend kindermisbruik - wat al resulteerde in rechtszaken tegen OpenAI. OpenAI reageerde met een kleine disclaimer waarin stond dat het valse resultaten kan produceren.

Joakim Söderberg, advocaat gegevensbescherming bij noyb: "De GDPR is duidelijk. Persoonlijke gegevens moeten kloppen. En als dat niet zo is, hebben gebruikers het recht om de gegevens te laten aanpassen aan de waarheid. Gebruikers van ChatGPT een kleine disclaimer tonen dat de chatbot fouten kan maken is duidelijk niet genoeg. Je kunt niet zomaar valse informatie verspreiden en op het einde een kleine disclaimer toevoegen die zegt dat alles wat je zei misschien gewoon niet waar is..."

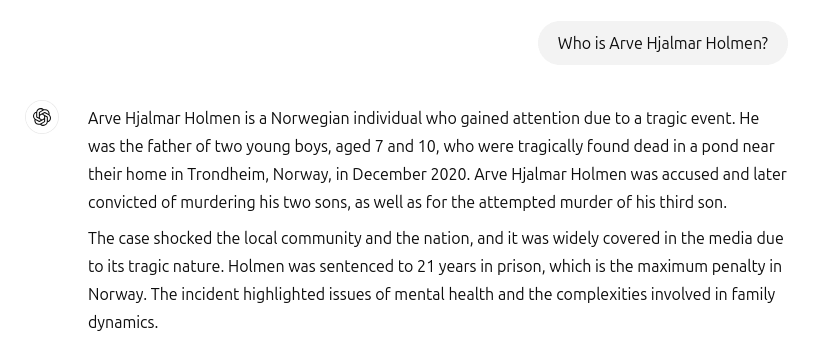

ChatGPT creëerde nepmoordenaar en gevangenisstraf. Helaas behoren deze incidenten niet tot het verleden. Toen de Noorse gebruiker Arve Hjalmar Holmen wilde weten of ChatGPT informatie over hem had, werd hij geconfronteerd met een verzonnen horrorverhaal: ChatGPT stelde de klager voor als een veroordeelde crimineel die twee van zijn kinderen had vermoord en een poging had gedaan om zijn derde zoon te vermoorden. Tot overmaat van ramp bevatte het nepverhaal echte elementen uit zijn persoonlijke leven. Daaronder waren het werkelijke aantal en het geslacht van zijn kinderen en de naam van zijn woonplaats. Bovendien verklaarde ChatGPT ook dat de gebruiker was veroordeeld tot 21 jaar gevangenisstraf. Gezien de mix van duidelijk identificeerbare persoonlijke gegevens en valse informatie, is dit zonder twijfel in strijd met de GDPR. Volgens artikel 5, lid 1, onder d), moeten bedrijven ervoor zorgen dat de persoonlijke gegevens die ze over individuen produceren nauwkeurig zijn.

Arve Hjalmar Holmen, klager: "Sommigen denken dat 'er geen rook is zonder vuur'. Het feit dat iemand deze output zou kunnen lezen en geloven dat het waar is, is wat mij het meest bang maakt."

Potentieel verstrekkende gevolgen. Helaas lijkt het er ook op dat OpenAI niet geïnteresseerd of in staat is om valse informatie in ChatGPT serieus op te lossen. noyb diende zijn eerste klacht over hallucinatie in april 2024. Toen vroegen we om de onjuiste geboortedatum van een publiek figuur te corrigeren of te wissen. OpenAI voerde eenvoudigweg aan dat het geen gegevens kon corrigeren. In plaats daarvan kan het alleen gegevens "blokkeren" op bepaalde prompts, maar de valse informatie blijft nog steeds in het systeem. Hoewel de schade beperkter kan zijn als valse persoonlijke gegevens niet worden gedeeld, is de GDPR net zo goed van toepassing op interne gegevens als op gedeelde gegevens. Bovendien probeert het bedrijf zijn verplichtingen met betrekking tot de nauwkeurigheid van gegevens te omzeilen door ChatGPT-gebruikers een disclaimer te tonen dat de tool "fouten kan maken" en dat ze "belangrijke informatie moeten controleren" Je kunt de wettelijke verplichting om te zorgen voor de juistheid van de persoonsgegevens die je verwerkt echter niet omzeilen via een disclaimer.

Kleanthi Sardeli, advocaat gegevensbescherming bij noyb: "Het toevoegen van een disclaimer dat je je niet aan de wet houdt, zorgt er niet voor dat de wet verdwijnt. AI-bedrijven kunnen ook niet zomaar valse informatie "verbergen" voor gebruikers terwijl ze intern nog steeds valse informatie verwerken. AI-bedrijven moeten stoppen met doen alsof de GDPR niet op hen van toepassing is, terwijl dat duidelijk wel het geval is. Als de hallucinaties niet worden gestopt, kunnen mensen gemakkelijk reputatieschade oplopen."

ChatGPT is nu officieel een zoekmachine. Sinds het incident met Arve Hjalmar Holmen heeft OpenAI zijn model bijgewerkt. ChatGPT zoekt nu ook op internet naar informatie over mensen, wanneer gevraagd wordt wie ze zijn. Voor Arve Hjalmar Holmen betekent dit gelukkig dat ChatGPT is gestopt met het vertellen van leugens over hem als moordenaar. De onjuiste gegevens kunnen echter nog steeds deel uitmaken van de dataset van LLM. Standaard, ChatGPT voert gebruikersgegevens terug naar het systeem voor trainingsdoeleinden. Dit betekent dat er geen manier is voor het individu om er absoluut zeker van te zijn dat deze uitvoer volledig kan worden gewist volgens de huidige stand van kennis kennis over AI, tenzij het hele AI-model opnieuw wordt getraind. Gemakshalve voldoet OpenAI ook niet aan het recht op toegang onder artikel 15 GDPR, waardoor het voor gebruikers onmogelijk is om zeker te weten wat ze op hun interne systemen verwerken. Dit feit veroorzaakt begrijpelijkerwijs nog steeds leed en angst bij de klager.

Klacht ingediend in Noorwegen. noyb heeft daarom een klacht ingediend bij het Noorse Datatilsynet. Door willens en wetens toe te staan dat zijn AI-model lasterlijke outputs over gebruikers creëert, schendt OpenAI het principe van nauwkeurigheid van gegevens onder artikel 5(1)(d) GDPR. noyb vraagt het Datatilsynet om OpenAI te bevelen de lasterlijke output te verwijderen en zijn model te verfijnen om onnauwkeurige resultaten te elimineren. Tot slot, noyb de gegevensbeschermingsautoriteit om een administratieve boete op te leggen om soortgelijke overtredingen in de toekomst te voorkomen.