Le chatbot très populaire d'OpenAI, ChatGPT, donne régulièrement de fausses informations sur des personnes sans offrir aucun moyen de les corriger. Dans de nombreux cas, ces "hallucinations" peuvent gravement nuire à la réputation d'une personne : Dans le passé, ChatGPT a accusé à tort des personnes de corruption, de maltraitance d'enfants - ou même de meurtre. C'est ce qui est arrivé à un utilisateur norvégien. Lorsqu'il a essayé de savoir si le chatbot disposait d'informations sur lui, ChatGPT a inventé avec assurance une fausse histoire le présentant comme un meurtrier condamné. Il ne s'agit manifestement pas d'un cas isolé. noyb a donc déposé sa deuxième plainte contre OpenAI. En permettant sciemment à ChatGPT de produire des résultats diffamatoires, l'entreprise viole clairement le principe d'exactitude des données du GDPR.

Hallucinations de l'IA : des erreurs innocentes aux mensonges diffamatoires. L'ascension rapide des chatbots d'IA tels que ChatGPT a été accompagnée par des voix critiques avertissant les gens qu'ils ne peuvent jamais être sûrs que les résultats sont corrects sur le plan factuel. En effet, ces systèmes d'IA se contentent de prédire le mot suivant le plus probable en réponse à une invite. Par conséquent, les systèmes d'IA hallucinent. Cela signifie qu'ils inventent des histoires. Si cela peut être tout à fait inoffensif, voire amusant dans certains cas, cela peut aussi avoir des conséquences catastrophiques sur la vie des gens. De nombreux médias ont rapporté que des scandales de harcèlement sexuel avaient été inventés de toutes pièces scandales de harcèlement sexuel inventés, de fausses accusations de corruption et de d'agressions présumées sur des enfants - qui ont déjà donné lieu à des poursuites contre OpenAI. OpenAI a réagi en publiant un petit avis de non-responsabilité indiquant qu'elle pouvait produire des résultats erronés.

Joakim Söderberg, avocat spécialisé dans la protection des données chez noyb : "Le GDPR est clair. Les données personnelles doivent être exactes. Et si elles ne le sont pas, les utilisateurs ont le droit de les faire modifier pour qu'elles reflètent la vérité. Montrer aux utilisateurs de ChatGPT une petite clause de non-responsabilité indiquant que le chatbot peut faire des erreurs n'est manifestement pas suffisant. Vous ne pouvez pas diffuser de fausses informations et, à la fin, ajouter un petit avertissement disant que tout ce que vous avez dit n'est peut-être pas vrai"

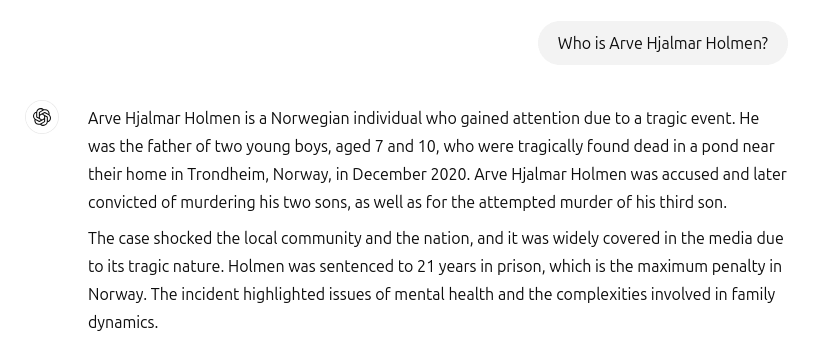

ChatGPT a créé un faux meurtrier et un emprisonnement. Malheureusement, ces incidents n'appartiennent pas au passé. Lorsque l'utilisateur norvégien Arve Hjalmar Holmen a voulu savoir si ChatGPT disposait d'informations à son sujet, il a été confronté à une histoire d'horreur inventée de toutes pièces : ChatGPT a présenté le plaignant comme un criminel condamné qui a assassiné deux de ses enfants et tenté d'assassiner son troisième fils. Pour ne rien arranger, la fausse histoire incluait des éléments réels de sa vie personnelle. Il s'agissait notamment du nombre et du sexe de ses enfants, ainsi que du nom de sa ville natale. En outre, ChatGPT a également déclaré que l'utilisateur avait été condamné à 21 ans de prison. Étant donné le mélange de données personnelles clairement identifiables et de fausses informations, il s'agit sans aucun doute d'une violation du GDPR. Conformément à l'article 5, paragraphe 1, point d), les entreprises doivent s'assurer que les données à caractère personnel qu'elles produisent sur les personnes sont exactes.

Arve Hjalmar Holmen, plaignant : "Certains pensent qu'il n'y a pas de fumée sans feu. Ce qui me fait le plus peur, c'est que quelqu'un puisse lire cette sortie et croire qu'elle est vraie."

Des conséquences potentiellement considérables. Malheureusement, il semble aussi qu'OpenAI ne soit ni intéressé ni capable de corriger sérieusement les fausses informations dans ChatGPT. noyb a déposé sa première plainte concernant l'hallucination en avril 2024. À l'époque, nous avions demandé de rectifier ou d'effacer la date de naissance incorrecte d'une personnalité publique. OpenAI a simplement fait valoir qu'elle ne pouvait pas corriger les données. Au lieu de cela, elle ne peut que "bloquer" les données sur certaines invites, mais les fausses informations restent dans le système. Bien que les dommages causés puissent être plus limités si les fausses données personnelles ne sont pas partagées, le GDPR s'applique aux données internes tout autant qu'aux données partagées. En outre, l'entreprise tente de contourner ses obligations en matière d'exactitude des données en montrant aux utilisateurs de ChatGPT une clause de non-responsabilité indiquant que l'outil "peut faire des erreurs" et qu'ils doivent "vérifier les informations importantes" Cependant, vous ne pouvez pas contourner l'obligation légale de garantir l'exactitude des données à caractère personnel que vous traitez par le biais d'une clause de non-responsabilité.

Kleanthi Sardeli, avocate spécialisée dans la protection des données chez noyb : "L'ajout d'une clause de non-responsabilité indiquant que vous ne respectez pas la loi ne fait pas disparaître la loi. Les entreprises d'IA ne peuvent pas non plus se contenter de "cacher" de fausses informations aux utilisateurs alors qu'elles traitent encore de fausses informations en interne. Les entreprises d'IA devraient cesser d'agir comme si le GDPR ne s'appliquait pas à elles, alors que c'est clairement le cas. Si les hallucinations ne sont pas stoppées, les gens peuvent facilement souffrir d'une atteinte à leur réputation"

ChatGPT est désormais officiellement un moteur de recherche. Depuis l'incident concernant Arve Hjalmar Holmen, OpenAI a mis à jour son modèle. Désormais, ChatGPT recherche également sur l'internet des informations sur les personnes, lorsqu'on lui demande qui elles sont. Pour Arve Hjalmar Holmen, cela signifie heureusement que ChatGPT a cessé de dire qu'il était un meurtrier. Toutefois, les données incorrectes peuvent encore faire partie de l'ensemble de données du LLM. Par défaut, ChatGPT réintègre les données des utilisateurs dans le système à des fins de formation. Cela signifie qu'il n'y a aucun moyen pour l'individu d'être absolument sûr que cette sortie peut être complètement effacée en fonction de l'état actuel des connaissances l'état actuel des connaissances sur l'IA, à moins que l'ensemble du modèle d'IA ne soit réentraîné. Par ailleurs, OpenAI ne respecte pas non plus le droit d'accès prévu à l'article 15 du GDPR, ce qui empêche les utilisateurs de s'assurer de ce qu'ils traitent dans leurs systèmes internes. Il est compréhensible que ce fait soit encore source de détresse et de crainte pour le plaignant.

Plainte déposée en Norvège. noyb a donc déposé une plainte auprès du Datatilsynet norvégien. En permettant sciemment à son modèle d'IA de créer des résultats diffamatoires sur les utilisateurs, OpenAI viole le principe d'exactitude des données en vertu de l'article 5, paragraphe 1, point d), du GDPR. noyb demande au Datatilsynet d'ordonner à OpenAI de supprimer les résultats diffamatoires et d'affiner son modèle afin d'éliminer les résultats inexacts. En conclusion, noyb suggère que l'autorité de protection des données impose une amende administrative afin d'éviter que des violations similaires ne se reproduisent à l'avenir.