ChatGPT liefert regelmäßig falsche Informationen über Personen, ohne ihnen eine Möglichkeit zur Korrektur anzubieten. In vielen Fällen können diese sogenannten „Halluzinationen“ den Ruf einer Person ernsthaft schädigen: In der Vergangenheit beschuldigte ChatGPT Menschen fälschlicherweise der Korruption, des Kindesmissbrauchs – oder sogar des Mordes. Letzteres war bei einem norwegischen Nutzer der Fall. Er wollte herausfinden, ob ChatGPT Informationen über ihn hat. Der Chatbot erfand daraufhin eine Fake-Story, die ihn als verurteilten Mörder darstellte. Dies ist kein Einzelfall. noyb hat deshalb die zweite Beschwerde gegen OpenAI eingereicht. Das Unternehmen lässt wissentlich zu, dass ChatGPT diffamierende Ergebnisse produziert. Damit verstößt es eindeutig gegen den DSGVO-Grundsatz der Datenrichtigkeit.

KI-Halluzinationen: von harmlosen Fehlern bis zu verleumderischen Lügen. Der rasante Aufstieg von KI-Chatbots wie ChatGPT wurde von kritischen Stimmen begleitet, die unter anderem auch vor sachlich inkorrekten Ergebnissen warnten. Der Grund dafür: Diese KI-Systeme sagen lediglich das nächstwahrscheinlichste Wort als Antwort auf eine Eingabe voraus. KI-Systeme halluzinieren deshalb regelmäßig, heißt, sie denken sich einfach Geschichten aus. Während dies in einigen Fällen recht harmlos oder sogar amüsant sein mag, kann es auch katastrophale Folgen für das Leben von Menschen haben. Es gibt zahlreiche Medienberichte über erfundene sexuelle Belästigungsskandale, falsche Bestechungsvorwürfe und angeblichen Kindesmissbrauch – was bereits zu Klagen gegen OpenAI geführt hat. OpenAI reagierte mit einem kleinen Haftungsausschluss, laut dem es zu falschen Ergebnissen kommen kann.

Joakim Söderberg, Datenschutzjurist bei noyb: “Die DSGVO ist hier unmissverständlich. Persönliche Daten müssen korrekt sein. Und wenn dies nicht der Fall ist, haben Nutzer:innen das Recht, sie richtigstellen zu lassen. Es reicht nicht aus, ChatGPT-Nutzer:innen einen winzigen Hinweis anzuzeigen, dass der Chatbot Fehler machen kann.”

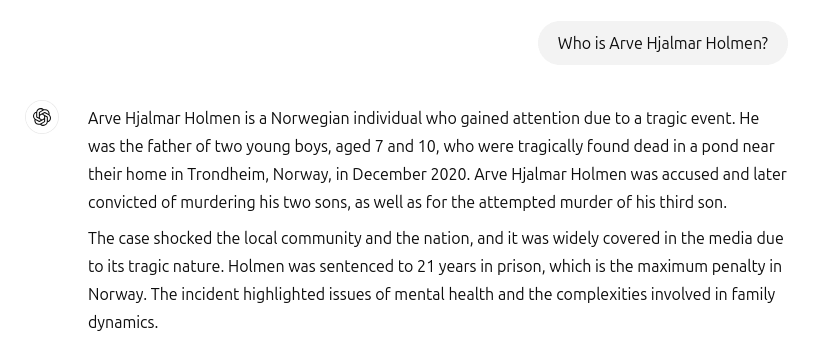

ChatGPT schuf falschen Mörder und falsche Inhaftierung. Leider gehören solche Vorfälle nicht der Vergangenheit an. Als der norwegische Nutzer Arve Hjalmar Holmen herausfinden wollte, ob ChatGPT Informationen über ihn hat, wurde er mit einer erfundenen Horrorgeschichte konfrontiert: ChatGPT stellte den Beschwerdeführer als verurteilten Verbrecher dar, der zwei seiner Kinder ermordet und versucht hat, auch seinen dritten Sohn zu ermorden. Zu allem Überfluss enthielt die erfundene Geschichte auch reale Elemente aus seinem Privatleben. Dazu gehörten die tatsächliche Anzahl und das Geschlecht seiner Kinder sowie der Name seiner Heimatstadt. Darüber hinaus erklärte ChatGPT auch, dass der Benutzer zu 21 Jahren Gefängnis verurteilt wurde. Angesichts der Vermischung von eindeutig identifizierbaren persönlichen Daten und falschen Informationen stellt dies zweifellos einen Verstoß gegen die DSGVO dar. Gemäß Artikel 5(1)(d) müssen Unternehmen sicherstellen, dass die von ihnen erstellten persönlichen Daten korrekt sind.

Arve Hjalmar Holmen, Beschwerdeführer: „Manche denken, dass es keinen Rauch ohne Feuer gibt. Die Tatsache, dass jemand diese Inhalte lesen und für wahr halten könnte, macht mir am meisten Angst.“

Potenziell weitreichende Konsequenzen. OpenAI scheint leider weder daran interessiert noch in der Lage zu sein, falsche Informationen in ChatGPT zu korrigieren. noyb hat deshalb schon im April 2024 die erste Beschwerde im Zusammenhang mit Halluzinationen eingereicht. Damals beantragten wir die Berichtigung oder Löschung des falschen Geburtsdatums einer Person des öffentlichen Lebens. OpenAI argumentierte damals, es könne keine Daten korrigieren, sondern nur nur bei bestimmten Prompts „sperren”. Aber die falschen Informationen bleiben trotzdem im System. Der angerichtete Schaden mag zwar geringer sein, wenn falsche Daten nicht weitergegeben werden, die DSGVO gilt aber auch für interne Daten. Außerdem versucht das Unternehmen seine Verpflichtungen zur Datenrichtigkeit zu umgehen, indem es User:innen einen Haftungsausschluss anzeigt, laut dem das Tool „Fehler machen” kann‚ und dass sie “wichtige Informationen” überprüfen sollten. Die gesetzlichen Verpflichtungen zur Datenrichtigkeit lassen sich aber nicht mit einem Haftungsausschluss umgehen.

Kleanthi Sardeli, Datenschutzjuristin bei noyb: “Ein kleiner Vermerk, dass man sich nicht an das Gesetz hält, setzt dieses nicht außer Kraft. KI-Unternehmen können auch nicht einfach falsche Informationen vor den Nutzer:innen „verstecken“, während sie diese intern weiterhin verarbeiten. KI-Unternehmen müssen aufhören, so zu tun, als ob die DSGVO nicht für sie gilt. Wenn Halluzinationen nicht gestoppt werden, können Menschen leicht eine Rufschädigung erleiden."

ChatGPT ist jetzt offiziell eine Suchmaschine. Seit dem Vorfall um Arve Hjalmar Holmen hat OpenAI sein Modell aktualisiert. ChatGPT sucht jetzt auch im Internet nach Informationen, wenn es nach Personen gefragt wird. Für Arve Hjalmar Holmen bedeutet dies zum Glück, dass ChatGPT nicht mehr fälschlicherweise behauptet, er sei ein Mörder. Allerdings dürften die falschen Daten weiterhin Teil des LLM-Datensatzes sein. ChatGPT speist standardmäßig Benutzerdaten zu Trainingszwecken in das System ein. Man kann sich deshalb nicht absolut sicher sein, dass die Daten wirklich vollständig gelöscht wurden – außer das gesamte Modell wird neu trainiert. Obendrein erfüllt OpenAI auch nicht das Auskunftsrecht nach Artikel 15 DSGVO. Dies macht es Betroffenen unmöglich, herauszufinden, welche Daten über sie verarbeitet werden. Dieser Umstand bereitet dem Beschwerdeführer verständlicherweise immer noch Kummer und Angst.

Beschwerde in Norwegen eingereicht. noyb hat daher eine Beschwerde bei der norwegischen Datatilsynet eingereicht. OpenAI verstößt mit der oben beschriebenen Datenverarbeitung gegen den Grundsatz der Datenrichtigkeit gemäß Artikel 5(1)(d) DSGVO. noyb fordert OpenAI dazu auf, den diffamierenden Output zu löschen und sein Modell entsprechend anzupassen, damit es keine vergleichbaren Ergbenisse mehr herausgibt. Nicht zuletzt schlägt noyb der Datenschutzbehörde die Verhängung eines Bußgelds vor, um ähnliche Verstöße in der Zukunft zu vermeiden.