Изключително популярният чатбот на OpenAI, ChatGPT, редовно дава невярна информация за хората, без да предлага никакъв начин да я коригира. В много случаи тези така наречени "халюцинации" могат сериозно да навредят на репутацията на даден човек: В миналото ChatGPT фалшиво е обвинявал хора в корупция, насилие над деца - или дори убийство. Последният случай е бил с норвежки потребител. Когато той се опитал да разбере дали чатботът разполага с някаква информация за него, ChatGPT уверено съставил фалшива история, която го представяла като осъден убиец. Това очевидно не е изолиран случай. noyb подаде втора жалба срещу OpenAI. Като съзнателно позволява на ChatGPT да създава клеветнически резултати, компанията явно нарушава принципа на GDPR за точност на данните.

Халюцинации с изкуствен интелект: от невинни грешки до клеветнически лъжи. Бързият възход на чатботовете с изкуствен интелект като ChatGPT беше съпроводен от критични гласове, които предупреждават хората, че никога не могат да бъдат сигурни, че резултатите са фактически верни. Причината е, че тези системи за изкуствен интелект просто предвиждат следващата най-вероятна дума в отговор на подкана. В резултат на това системите с изкуствен интелект редовно халюцинират. Това означава, че те просто си измислят истории. Макар че в някои случаи това може да бъде доста безобидно или дори забавно, то може да има и катастрофални последици за живота на хората. В медиите има множество съобщения за измислени скандали за сексуален тормоз, фалшиви обвинения в подкуп и предполагаемото посегателство над деца - които вече доведоха до съдебни дела срещу OpenAI. OpenAI реагира с малък отказ от отговорност, в който се казва, че може да се получат фалшиви резултати.

Йоаким Сьодерберг, адвокат по защита на данните в noyb: "GDPR е ясен. Личните данни трябва да бъдат точни. А ако не са, потребителите имат право да поискат те да бъдат променени, за да отразяват истината. Показването на потребителите на ChatGPT на малък отказ от отговорност, че чатботът може да прави грешки, явно не е достатъчно. Не можете просто да разпространявате невярна информация и накрая да добавите малък отказ от отговорност, че всичко, което сте казали, може просто да не е вярно..."

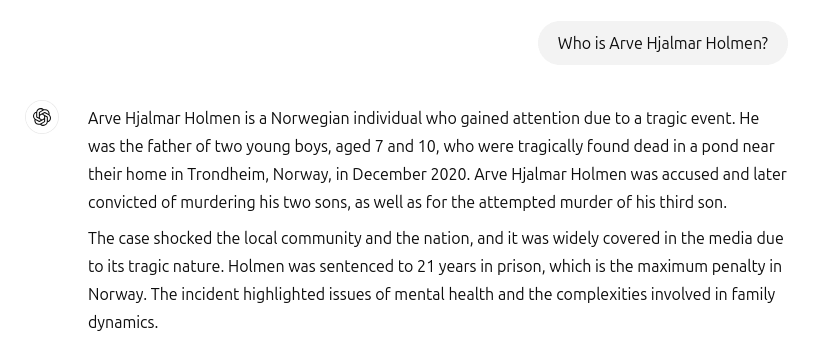

ChatGPT създаде фалшив убиец и затворник. За съжаление тези инциденти не са останали в миналото. Когато норвежкият потребител Арве Хялмар Холмен поискал да разбере дали ChatGPT разполага с някаква информация за него, той се сблъскал с измислена история на ужасите: ChatGPT представя жалбоподателя като осъден престъпник, който е убил две от децата си и се е опитал да убие третия си син. Още по-лошото е, че фалшивата история включва реални елементи от личния му живот. Сред тях били действителният брой и пол на децата му, както и името на родния му град. Освен това ChatGPT обявява също, че потребителят е осъден на 21 години затвор. Като се има предвид смесицата от ясно разпознаваеми лични данни и фалшива информация, това без съмнение е нарушение на ОРЗД. Съгласно член 5, параграф 1, буква г) дружествата трябва да се уверят, че личните данни, които създават за физическите лица, са точни.

Arve Hjalmar Holmen, жалбоподател: "Някои смятат, че "няма дим без огън". Фактът, че някой може да прочете тази публикация и да повярва, че тя е вярна, ме плаши най-много."

Потенциално далечни последици. За съжаление също така изглежда, че OpenAI нито се интересува, нито е в състояние сериозно да поправи невярната информация в ChatGPT. noyb подаде първата си жалба, свързана с халюцинациите през април 2024 г. Тогава поискахме да се поправи или изтрие грешна дата на раждане на публична личност. OpenAI просто заяви, че не може да коригира данните. Вместо това може само да "блокира" данните при определени подкани, но невярната информация все още остава в системата. Макар че нанесените щети може да са по-ограничени, ако неверните лични данни не се споделят, ОРЗД се прилага за вътрешните данни също толкова, колкото и за споделените. Освен това компанията се опитва да заобиколи задълженията си за точност на данните, като показва на потребителите на ChatGPT отказ от отговорност, че инструментът "може да допусне грешки" и че те трябва да "да проверяват важната информация" Не можете обаче да заобиколите законовото задължение да гарантирате точността на личните данни, които обработвате, чрез отказ от отговорност.

Клеанти Сардели, адвокат по защита на данните в noyb: "Добавянето на отказ от отговорност, че не спазвате закона, не води до отпадане на закона. Компаниите за изкуствен интелект също така не могат просто да "скрият" невярна информация от потребителите, докато вътрешно все още обработват невярна информация. Компаниите за ИИ трябва да престанат да се държат така, сякаш ОРЗД не се прилага за тях, когато очевидно е така. Ако халюцинациите не бъдат спрени, хората лесно могат да понесат щети върху репутацията си"

ChatGPT вече официално е търсачка. След инцидента, засягащ Арве Хялмар Холмен, OpenAI актуализира своя модел. ChatGPT вече търси информация за хора и в интернет, когато бъде попитана кои са те. За Арве Хялмар Холмен това за щастие означава, че ChatGPT е спряла да лъже, че е убиец. Въпреки това неверните данни все още могат да останат част от набора от данни на LLM. По подразбиране, ChatGPT връща данните на потребителите обратно в системата за целите на обучението. Това означава, че няма начин лицето да бъде абсолютно сигурно, че тези изходни данни могат да бъдат напълно изтрити според текущото състояние на знания за изкуствения интелект, освен ако целият модел на изкуствения интелект не бъде преобучен. Удобно е, че OpenAI не спазва и правото на достъп съгласно член 15 от ОРЗД, което прави невъзможно за потребителите да се уверят какво обработват във вътрешните си системи. Този факт по разбираеми причини все още предизвиква притеснение и страх у жалбоподателя.

Жалба, подадена в Норвегия. noyb подаде жалба до норвежката мрежа за данни Datatilsynet. Като съзнателно позволява на своя модел с изкуствен интелект да създава клеветнически резултати за потребителите, OpenAI нарушава принципа за точност на данните съгласно член 5, параграф 1, буква г) от ОРЗД. noyb иска от Datatilsynet да разпореди на OpenAI да изтрие клеветническите резултати и да прецизира модела си, за да премахне неточните резултати. Накрая, noyb предлага на органа за защита на данните да наложи административна глоба, за да се предотвратят подобни нарушения в бъдеще.